ビジネスにおいて法令情報は、単なるルール確認にとどまらず、事業判断やリスクマネジメントを支える基盤です。法令リサーチの精度とスピードが、そのままコンプライアンス体制の強度や意思決定の質を左右します。 ...

By Serena Wellen, VP Product Management, LexisNexis * 本サイトにリンクまたは掲載されている外部執筆者による見解は、LexisNexis Legal...

企業を取り巻く環境が急速に変化し、法務部門にはリスクマネジメントの“守り”に加え、事業を支える“攻め”の視点も求められています。 丸文株式会社では、現場に寄り添いながら全社的な法令遵守体制を強化し...

* 本サイトにリンクまたは掲載されている外部作成資料に記載された見解は、LexisNexis Legal & Professionalの見解を必ずしも反映するものではありません。 今月初めにローンチされた...

「法令を知らなかった」は通用しない ―法改正の“見逃し”が企業リスクに直結する今、田中が動いた。 LN製造株式会社のコンプライアンス強化とASONE導入事例 「知らなかった」が許されない時代。法改正の頻度と複雑さが増す中...

チャット形式で入力するだけで、文章や画像を自動でつくってくれる“生成AI”。いまや日常生活にも浸透してきているAIを、ビジネスシーンでどのように利用すればよいのか? 企業として使用する際に、法規制に触れることはないのか――?

そのような疑問に答えるために、AIに精通した弁護士が、生成AIの利用方法から最近の動向、今後の展望まで最新情報をご紹介するイベント「Lexis+ AI Roadshow 2025 AI時代における法務戦略 -リスクマネジメントの最前線と契約業務の革新-(主催:レクシスネクシス・ジャパン株式会社)」を大阪と東京で開催しました。コーポレート法務業務、特に契約業務に携わる方のAI対策・活用にお役立てください。

本記事では、東京会場にゲストスピーカーとして登壇した、森・濱田松本法律事務所外国法共同事業の田中弁護士の講演をレポートします。

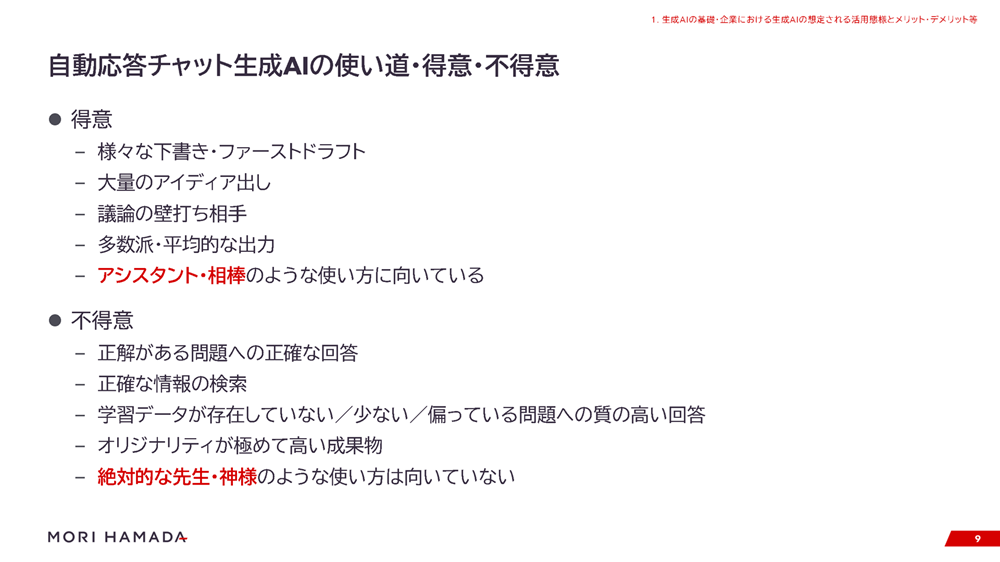

生成AIの弱点や得意・不得意は?

ご存じの方も多いと思いますが、ChatGPTなど、現在主流となっている生成AIは“大規模言語モデル”を利用しています。人間のようにさまざまな物事を理解して感情や思想に基づいて出力しているのではなく、基本的に確率論で動くのが生成AIです。

「機械学習を踏まえて、ある言葉の次に来る確率が高い単語を“数珠つなぎ”のようにつなげる」という仕組みなので、その前提を理解したうえで利用することが必要になります。

そして、そのような仕組みのため、事実に反する生成結果を出力する“ハルシネーション(幻覚)”ということが起きます。たとえば、“実際は存在しない著者”と“存在しないタイトル”を組み合わせて、あたかも存在する書籍のように出力してしまうことがあります。

アメリカのリーガル分野で実際に起きた有名なケースとして、弁護士がChatGPTに生成させた裁判例を引用したところ、実在しない裁判例だということがありました。ですから、そういったことが起こりうると理解しておくことが大切です。

さらに、“学習している情報の時点の古さ”という問題もあります。大規模言語モデルを利用する生成AIは、機械学習を行った時点の情報データをもとに成果物を出力するため、生成されたものは最新の情報を踏まえたものとは限りません。

しかし、最近の進化したAIでは、インターネットで最新情報を取り込む機能によってこの弱点を補っています。また、プラグインによって、たとえば「レストランサイトの予約情報などの最新データを取り込んで回答し、利用者がAIと会話することで会食の計画を立てて、表示されたリンクURLから実際の予約を行う」ということも可能になります。

現時点で、生成AIには以下のような得意・不得意なことがあります。

※田中弁護士 資料より

不得意分野の“正解がある問題への正確な回答”ができることもありますが、どうしてもハルシネーションが起こるので、絶対的な正解を出すには向いていません。解法を理解せずに確率論で回答するため、中学校レベルの数学の文章題を間違えることもあります。

また、生成AIは検索ツールではないので、正確な情報の検索は検索エンジンを使ったほうがよいでしょう。

“絶対的な先生・神様”のような使い方ではなく、“アシスタント・相棒”として「少しでも役に立てばいい」と考えれば、生成AIは“使える”ものだと思います。そして、現在は不得意なことも、技術が発展すればどんどん得意になっていく可能性があります。

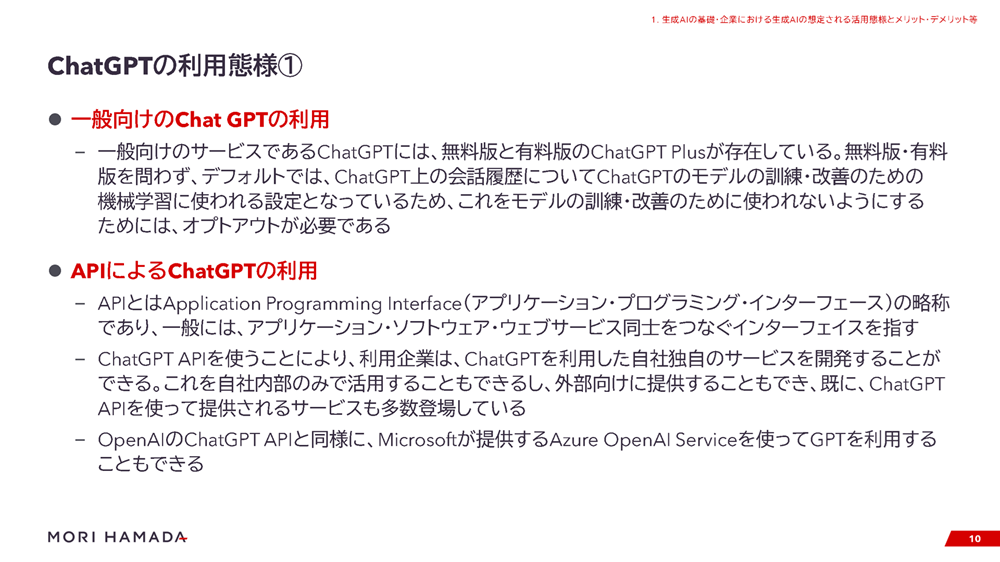

企業が“API”を活用するためのヒント

生成AIとして有名なChatGPTには、一般向けのモデルと、アプリ・ソフトウェア・Webサービス同士をつなぐ“API(アプリケーション・プログラミング・インターフェース)”を用いたものがあります。

※田中弁護士 資料より

企業さんの場合はAPI を使うことが多いかと思いますが、こちらは一般向けのものとはちがって、自社独自のAIサービスをつくることが可能です。また、マイクロソフトが提供しているAZURE OpenAI Serviceを使ってGPTを利用することもできます。

そして、APIは、ユーザーがオプトイン同意しない限り、ユーザーから提出されたデータは機械学習に使用されないとされています。

さらに、一般向けモデルとはちがい、いわゆる“データ処理契約(DPA)”の締結が可能です。これによって「EU一般データ保護規則(GDPR)」を意識した契約が結べて、個人情報・個人データの扱いに関する委託先の管理などが行いやすくなります。

APIを活用する方法には、“ファインチューニング”と“プロンプト・エンジニアリング”という2つの手法があり、費用対効果の観点からどちらの手法を採用するか決めることがポイントです。前者は既存のAIモデルをチューニングして自社向けモデルを開発するものです。相応の費用がかかり、改変しすぎると出力の精度がかえって下がることもあります。

プロンプト・エンジニアリングは、出力の精度を上げるためにプロンプト(生成AIに対する指示)に工夫を加える技術です。たとえば、APIに自社のさまざまなデータを取り込むと、そこからプロンプトに対して有用なデータを取り出して、出力成果物の精度を向上させることができます。

また、“RAG(検索拡張生成)”は、データベースから大量の独自のデータを取り組んだうえでの回答を出力を可能にする手法であり、これも、プロンプト・エンジニアリング手法の1つだと言えます。

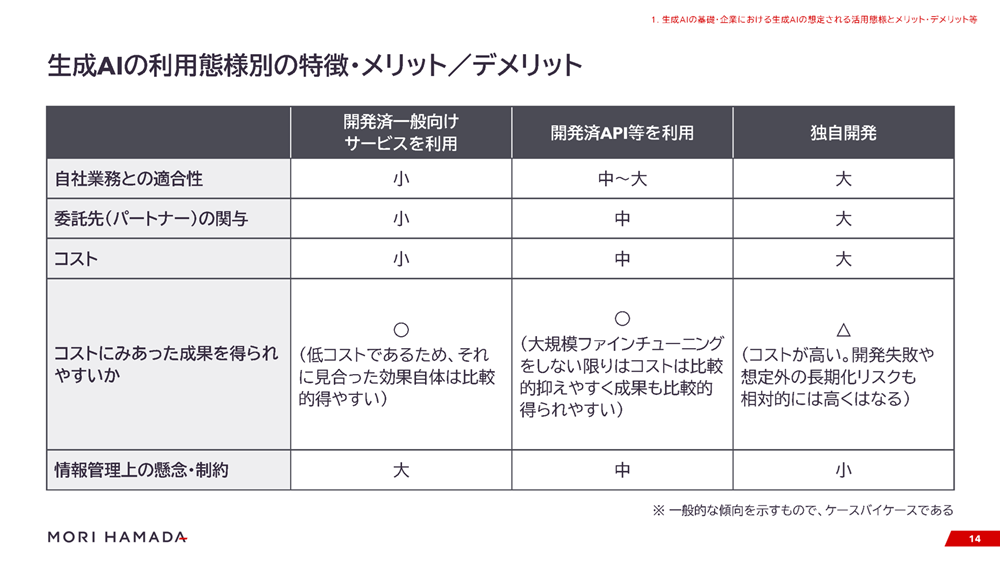

※田中弁護士 資料より

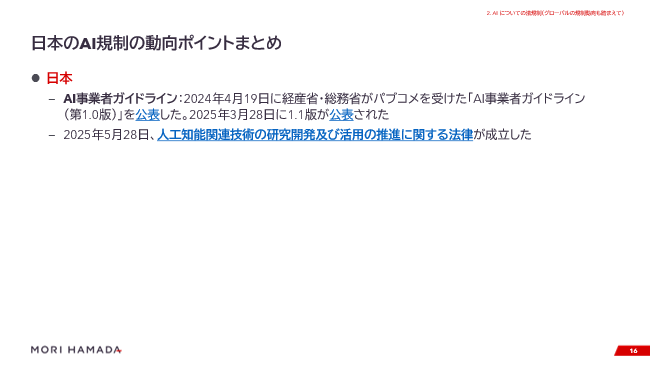

日本とEUのAI規制の動向

日本のAI規制の主な動向は、以下のようになります。

※田中弁護士 資料より

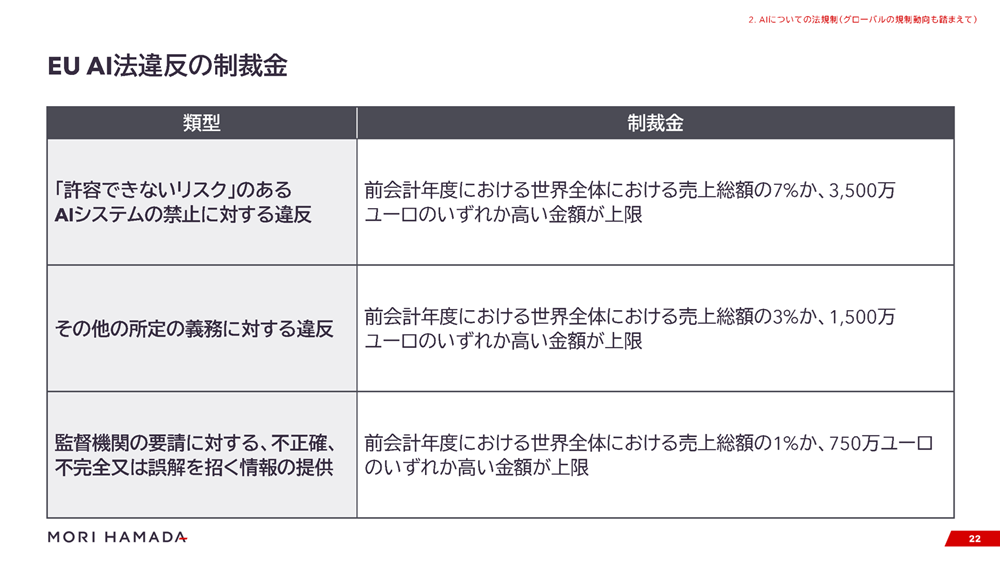

世界的に見てもさまざまなAI規制の動きがあるなかでも、すでに一部適用が始まっているEUの通称「EU AI法」は非常に重い制裁があって厳しいものです。

※田中弁護士 資料より

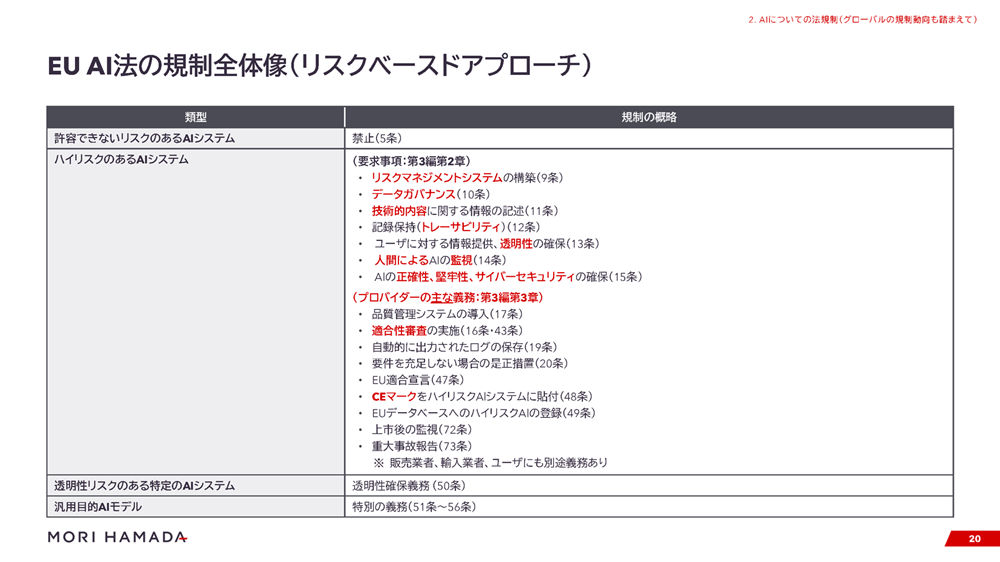

EU AI法は“リスクベースドアプローチ”になっていて、上図の4カテゴリーがあります。「禁止AI」とも言われる「許容できないリスクのあるAIシステム(以下、禁止AI)」はすべて禁止で、「ハイリスクのあるAIシステム(以下、ハイリスクAI)」にはさまざまな規制がかけられています。

規制対象は、「AIシステム」と「汎用目的AIモデル」で、たとえば企業が汎用目的AIモデルを使って自社独自のAIシステムをつくった場合も対象になります。チャットボットや画像生成AIなどもすべてAIシステムに含まれ、条文のほとんどがAIシステムに関するものです。

「禁止AI」の適用は2025年2月に始まっていて、汎用目的AIモデルは8月2日、その他については原則的適用開始日が2026年8月2日です。

そして、下図のように義務や制裁金が課せられます。

※田中弁護士 資料より

各カテゴリーの定義を見ていくと、「禁止AI」は人々への脅威と見なされるもので、EUのAI法で類型が決められています。たとえば、ひとの潜在意識を操作する技術やソーシャルスコアリング(社会的行動や個人の特徴に基づく信用格付け)への利用などがこれにあたります。また、「職場や教育機関での感情推測」を行うAIも含まれています。このようなAIには一定のニーズがあるとは思いますが、EUでは禁止されているため注意が必要です。

そして、「ハイリスクAI」は、「安全コンポネントであるハイリスクAI」と「特定の領域のハイリスクAI」の2つに大きく分類されます。後者のほうが有名で、こちらしか認識されていないことも多いですが、前者にも注意が必要です。

もともと、EUにはさまざまな製品の安全性を定めた「EU整合法令」があり、これに紐付ける形でハイリスクAIの定義が定められています。たとえば、EU整合法令で規制されている製品(例:おもちゃ)の安全性を確保するためのシステムにAIが使われており、その製品を市場に出すには、元々EU整合法令上、第三者適合性評価が義務付けられているのであれば、EU AI法の「安全コンポネントであるハイリスクAI」の規制対象になります。

このように既存の法令との関係で、「安全コンポネントであるハイリスクAI」と見なされるものもあるため、注意しましょう。

そして、「特定の領域のハイリスクAI」には、求人広告のターゲティングや応募書類の分析など“人材募集や選抜に使用される雇用関連AIシステム”や、労働関係の契約条件・昇進・解雇などに影響する決定を行う“労働者管理系のAI”などが含まれています。

HR系のAIはハイリスクAI、場合によっては禁止AIに該当する場合があるため、気をつける必要があります。EU AI法で全てのAIが規制されている訳ではありませんが、HR系に限らず、「自分たちには関係ない」と思っていても規制される場合があり得るので、注意してください。

さまざまなハイリスクAIがありますが、現在は条文しかないため、今後つくられる整合規格を守ることが基本的・現実的な対策になると思います。

「透明性リスクがある特定AIシステム」に関しては、たとえば生成AIでつくった画像やディープフェイクであれば、「人間ではなく、AIが生成したもの」と説明することが必要になるといった規制がかかっています。

「汎用目的AIモデル」を自社で開発する企業は限られると思いますが、場合によってはファインチューニングなどでAIを自分で開発すると、規制の定義に触れることがあります。特に、高い影響力を持つ“システミックリスク”という重大なリスクがあると、さらに規制が重たくなるので注意が必要です。

EU AI法は非常に厳しい内容なため、現在、少し緩和をしようという議論が行われています。どの程度の緩和になるかわかりませんが、今後発表される実務規範・整合規格・ガイドラインなどの内容に注目していく必要があります。

混乱するアメリカと、AI規制が進む中国

アメリカは少し混乱した状況になっていまして、もともとはバイデン大統領がAI規制に関する大統領令を公表しましたが、トランプ政権になって撤回されました。そして、2025年5月に下院を通過した「One Big Beautiful Bill Act」(OBBB)という歳出・税制法案のなかで「10年間、いかなる州や政治的下位区分も、AIの規制はできない」と明記されました。

現時点(2025年5月29日時点)では、上院は通過しておらず、上院通過のハードルは一般論としては高いと思われますが、こうした法案が下院を通過すること自体にアメリカのトランプ政権下におけるAI政策の動向があらわれていると言えそうです。

(注)その後、OBBBは、上院においては最終的に、AI規制の禁止に関する条項は削除したうえで、2025年7月4日に成立した。また、2025年7月23日に、Winning the Race AMERICA’S AI ACTION PLANが公表されており、過度に過剰なAI規制を導入する州への連邦資金の提供を制限する方針が示されている。

連邦法にもいろいろな動きがありますが、EU AI法のような統一的なものはできていない状況です。しかし、2025年5月には、ディープエフェクトを含む「同意を得ない性的な私的画像をSNSなどで公開することを連邦法上の犯罪とする」という「Take It Down Act」が、AI関連の法律として成立しています。

そして、すでに多くの州法が存在します。州法の主要なテーマの例として“責任あるAIとアルゴリズム規制”や“自動化された意思決定”、雇用関係、医療関係、選挙関係などがあります。

特にカリフォルニアでは「ディープフェイク規制」など多くのAI関連州法が議会を通過していて、ほかにもニューヨーク市の「人事・採用とAIに関する規制」、テネシー州の肖像や声の使用に関する「エルビス法」など、さまざまな個別州法が存在しているのが現状です。

また、中国には「生成AIサービス管理暫定弁法」という生成AIに特化した法律があって、共産主義に反するような出力をするようなAIは禁止されています。

さらに、アルゴリズム推薦に関する規制「インターネット情報サービスアルゴリズム推薦管理規定」や、中国が非常に警戒しているフェイクニュースやディープフェイクなどを規制する「インターネット情報サービスの複層合成の管理に関する規則」があり、AI規制が進んでいます。

情報の“入力”と“出力”に注意が必要

企業が生成AIを使用する際、情報の“入力”と“出力”の両面のリスクを留意する必要があります。

情報を入力する際は、個人情報保護法やプライバシー、機密(秘密)情報、そしてバイアスがかかることによる公平性の問題などの倫理的な問題を考慮することが大切です。また、著作権などの知的財産権の侵害に懸念が生じるような情報の入力を行わないようにしましょう。

出力に関しては、まず、先ほど申し上げたハルシネーションによる誤情報や、機械学習時点での古い情報に基づく出力などに気をつけることが大切です。

また、AIの出力結果を過度に信じてしまう“自動化バイアス”のリスクもあります。それにより、人間の意思決定や感情が操作されてしまったり、AIで生成されたことに気づかなかったりして、重要な経営判断などを行うリスクもあり得ます。

AIを利用する際は「パフォーマンスレベルが維持され、誤った判断をしないようになっているか」という“堅牢性”の視点を持つことが必要です。

さらに、社内ルールや教育などで“人間中心の考え方”を注意喚起することや、「これは生成AIが出力したので、私は知りません」といった言い訳ができないための“リテラシーの向上”も重要になります。

そして、「知的財産権やプライバシーの侵害、名誉棄損などの不法行為、人間の尊厳などを害するような違法・不当な情報、非倫理的な情報などが出力されていないか」という点にも注意が必要です。民事上の不法行為や刑事責任、自社のレピュテーションの問題につながるリスクも考慮しましょう。

そのほかの注意点として、人間の指示ではなく生成AIが自律的に生成したものは、著作権など知的財産権を取得できません。知的財産権を確実に得たいコンテンツの生成に、生成AIを使う場合には慎重な検討が必要ですわ。

加えて、業法違反や利用規約違反になるような利用をしないための社内ルール・教育での注意喚起、「AIを使用した」とわかるように透明性をもって説明することなども、企業として法的・倫理的責任を果たすうえで重要なポイントになります。

これらのリスクは、社内向け・外部向けともに発生する可能性があるため、注意が必要です。

営業秘密・機密情報の取り扱い

法務業務で生成AIを利用する場合、「営業秘密・機密情報の取り扱いがむずかしい」と感じていらっしゃる方は多いと思います。

営業秘密は不正競争防止法で“秘密管理性”“有用性”“非公知性”の3要件が定められていて、特に“秘密管理性”では従業員との認識可能性を確保することが必要です。もし、営業秘密を生成AIに入力した場合、“秘密管理性”が失われ、「営業秘密が、営業秘密ではなくなってしまう」可能性があります。

また、営業秘密が機械学習されて外部に開示されてしまうと“非公知性”が失われます。

そのため、利用にあたって機密保持に関する定めやセキュリティ措置を確認することも重要です。たとえば、APIの場合は守秘義務が定められている一方で、一般向けの生成AIでは明記されていないことがあるので、その部分をきちんと理解しておきましょう。

さらに、守秘義務があっても、自社にとって非常に重要な情報については「本当に入力が必要か」という必要性を判断することも大切です。

自社の営業秘密ならば自社でリスクテイクすればある意味よいとも言えるのですが、第三者の機密情報についてはNDA(秘密保持契約)で保護されているため、自社でリスクテイクすれば良いという問題ではなく、第三者との関係でNDA違反にならないかという問題が生じることに注意が必要です。生成AIを想定したNDAはまだあまり浸透していませんが、今後NDAの内容も生成AIを意識した内容に工夫していくことも必要になるでしょう。

AIの利用・開発と契約

AIの開発・利用に関する契約を検討する際、経産省の「AIの利用・開発に関する契約チェックリスト」が参考になります。さまざまなパターンを想定していて、「自社の立場に応じて、契約のどういった点に注目したらいいか」が整理されていますので、まだ見たことない方はぜひ一度ご覧ください。

各生成AIの利用規約の内容は多岐にわたりますが、「AI生成物であると示すことが義務づけられる」「著作権の帰属や権利行使制限などがある」「商用利用の可否・利用禁止行為」などのケースがあります。また、「生成AI事業者によるデータの利活用の範囲」や「生成AI事業者のブランドなどの保護」などもチェックしておくことが必要です。

社内ルールを整備するために

生成AIに関する社内ルールを整備する場合に参考となる有名なひな形としてディープラーニング協会の生成AIの利用ガイドラインがあります。このひな形は敢えて厳格に作られており、「禁止事項などが多くて厳しすぎる」と感じるかもしれませんが、このひな形の内容通りにする必要はありません。あくまで“ベース”と考えて、自社が使用するAIサービスなどに応じて修正していけばよいと思います。

特に、まだ社内ルールをつくっていない企業さんは、あとから改定しても問題はないので、まずは短くても抽象的でもルールを定めておくことが大切です。

さらに、「禁止・許可の2区分にするか。個別承認事項も入れた3区分にするか」「自分で判断できない場合に気軽に相談できる窓口の設置」「AIで生成したものを明確化する義務」「生成AIの使用状況の記録を残す義務」などが、社内ルールを整備するポイントになります。

また、この社内ルール制定を機会に、自社の情報管理規定の機密区分を見直す企業さんもありますし、部署・サービスごとに異なるルールや特則の設置なども有効です。そして、一旦策定したルール状況のチェックや定期的な見直しを行いながら、自社に適したルールを整備していってください。

プロフィール

|

|

森・濱田松本法律事務所外国法共同事業 2007年、弁護士登録(第二東京弁護士会)。2014年、ニューヨーク州弁護士登録。慶應義塾大学大学院法務研究科修了。ニューヨーク大学ロースクール修了(競争・発明・情報法学修士)。Clayton Utz法律事務所(シドニー)での執務を経て、学術・研究活動にも注力し、慶應義塾大学法学研究科特任教授(非常勤)などの教育機関、国の研究プロジェクトでも活動。AI、データ・プライバシー、デジタル法制、知的財産、IT分野を主要取扱分野とする。「日経企業法務税務弁護士調査」の2024年に活躍した弁護士ランキングで、AIテックデータ分野で企業が選ぶ弁護士第3位に選出。著作・論文も多数。[事務所サイト] |

法的文書ドラフト、調査、洞察のための統合ソリューション「Lexis+ AI」

レクシスネクシスでは、ユーザーに併せてパーソナライズされるAIアシスタント「Protégé」を搭載したソリューション「Lexis+ AI」を提供しています。「Lexis+ AI」は、「Lexis+」の膨大なデータソースの中からユーザーが必要とする情報をAIで抽出。海外法務業務で必要となる、リサーチや文書作成業務の効率化を実現します。

Lexis+のコンテンツについて

・Legal Research :判例、法令、Law Review、Journal等の検索

・Practical Guidance :各分野のPractice Note、チェックリスト、Q&A、契約書雛形など

・Litigation Analytics :裁判官・裁判所の過去の傾向や、弁護士のキャリア、訴訟実績

・Document Analysis :文書の法的観点や、同類のBrief等を自動的に探し出す

・Legal News Hub :ニュース配信サービスの一部の情報を提供

Lexis+ AIのリーガル生成AIによる主な機能

・会話型検索 :対話するように回答を絞り込み

・ドラフト :ありとあらゆる原稿を瞬時に下書き

・要約 :短時間での法的要約

・分析 :ドキュメントアップロード